Archive for the ‘Knowledge management’ Category

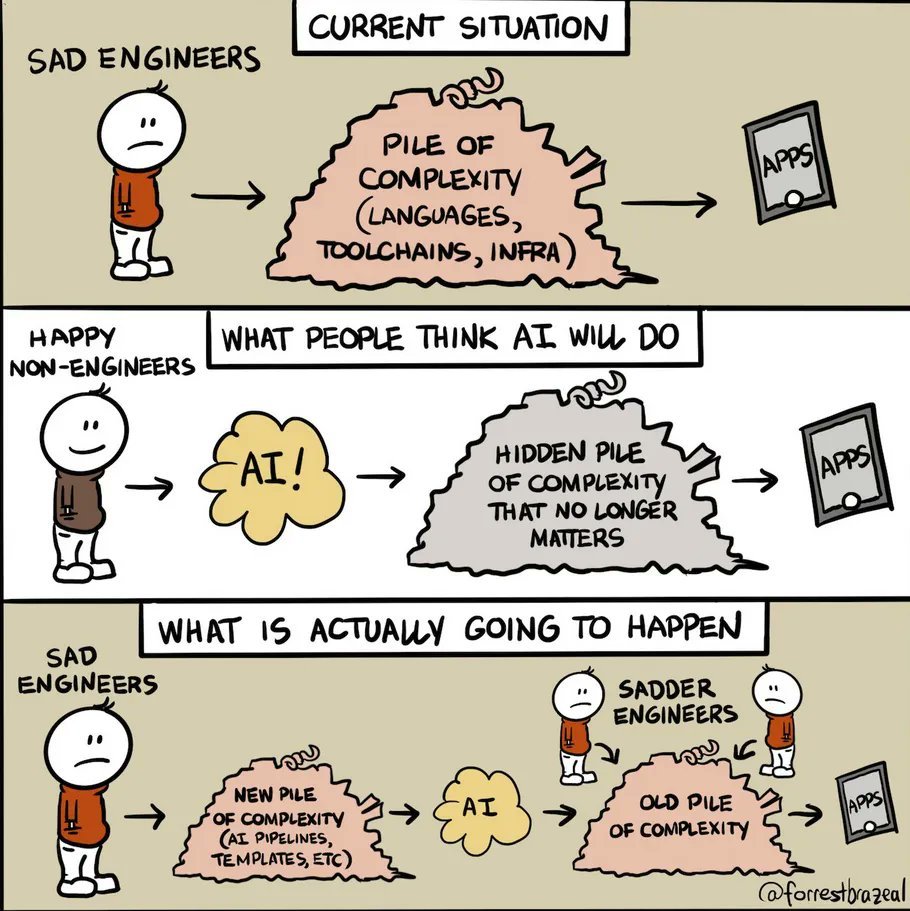

AI, the Sad Engineers and the Myth

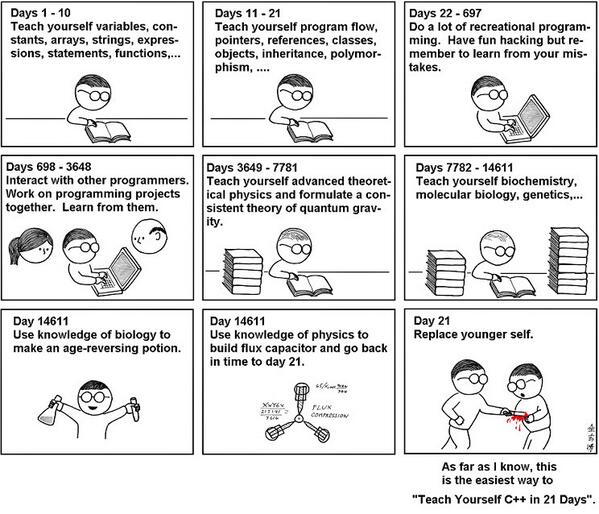

Friday, March 1st, 2024Great cartoon by Forrest Brazeal (@forrestbrazeal).

As a bonus, the post of the day from François Chollet (@fchollet).

My view of the capabilities of LLMs is probably far below that of the median tech industry person. And yet, the more time passes the more I realize my 2023 views were actually overestimating their future potential and current usefulness.

Parallel to self-driving: circa 2016-2017…

— François Chollet (@fchollet) March 1, 2024

My view of the capabilities of LLMs is probably far below that of the median tech industry person. And yet, the more time passes the more I realize my 2023 views were actually overestimating their future potential and current usefulness.

Parallel to self-driving: circa 2016-2017 my view on the timeline for full-scale self-driving deployment was much more pessimistic than most people in the industry — I was envisioning ~2023, when everyone else targeted 2020 or earlier. And yet, as time passed I started realizing that I was being grossly overoptimistic.

Of course factualism doesn’t sell — if I wanted to be more of an AI influencer I would have to be constantly tweeting about how AI is going to replace all programmers and doctors and so on in less than a year. That sounds exciting and positive, and it gets great engagement!

Instead, I’m giving the impression of being an AI pessimist — despite having being extra-bullish on deep learning and AI for over 10 years straight.

I have been a huge believer in AI’s potential for a long time. Still am today. But I’m allergic to mindless hype.

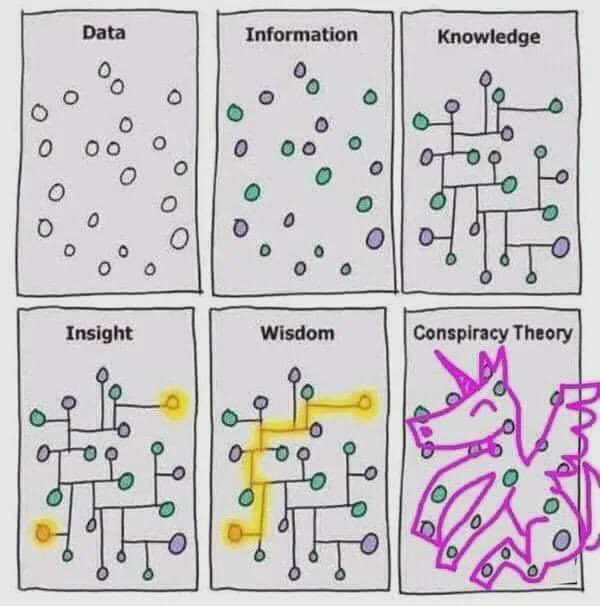

The spirits say…

Friday, November 12th, 2021A picture is worth a thousand words

Thursday, October 21st, 2021AlphaGo Zero Cheat Sheet

Friday, January 31st, 202020 cognitive biases that screw up your decisions

Sunday, October 27th, 2019From Samantha Lee and Shana Lebowitz in Business Insider

Staff virtuel

Monday, February 19th, 2018Le Staff virtuel naît du concept de Ligne de vie que nous ne décrirons pas ici. Il suffira de dire que la Ligne de vie est un outil basé sur le principe qu’une personne peut souhaiter « gérer sa santé comme un projet » et que cette démarche passe par la matérialisation de l’équipe de santé qui « l’entoure » et par une vision au cours du temps des préoccupations de santé, de ce qui a déjà été réalisé et de la qualité de suivi du risque.

La Ligne de vie est une idée déjà ancienne, née au tournant du siècle, développée au début des années 2000 avec le support de plusieurs URMLs (alors regroupées dans le GUEPARD, Groupe InterUnion Échanges et PARtage des Données) puis mise sous le boisseau par le caractère exclusif du DMP. La Ligne de vie sera lancée cette année dans une version plus mature et générique qui postule qu’une personne ne peut logiquement pas se résumer à son projet de santé.

Le Staff virtuel est né, au sein du CISP Club, de l’intérêt de ne pas voir la Ligne de vie comme une pancarte, mais comme un objet en trois dimensions (une sorte de « cake » étiré au cours du temps) qu’il serait possible de découper en tranches.

Les tranches longitudinales seraient assez bien des « vues spécialisées », typiquement des pancartes construites pour une préoccupation de santé donnée (une pathologie, un risque…) tandis que les tranches perpendiculaires représentent les informations connues à un moment précis.

Le Staff virtuel trouve ainsi sa genèse de la considération que « la tranche d’aujourd’hui » pourrait bien fournir « l’espace de la prise de décision », par exemple l’interface d’une consultation médicale moderne. Cette hypothèse a été explorée dans le cadre d’un projet de recherche en collaboration avec l’équipe du Professeur Degoulet à l’HEGP (ex Broussais) et l’équipe INRIA Acacia alors encadrée par Rose Dieng (malheureusement décédée depuis).

L’état de l’art en terme de structuration de la consultation médicale est plutôt chaotique. L’approche classique, déjà ancienne (développée par le Docteur Lawrence Weed dans les années 60) consiste à organiser la consultation par problèmes (approche « orientée problèmes » ou POMR pour « problem oriented medical record ») et à recueillir pour chaque problème le déroulé de la consultation selon les étapes SOAP (pour faire simple : Subjective (motifs), Objective (examen clinique), Assesment (discussion diagnostique) et Procedure (conduite à tenir)).

Cette « grille » a le grand mérite de conduire à analyser les problèmes traités lors de la consultation, et à noter proprement ce qui a été réalisé ou planifié pour chacun d’entre eux, d’où son succès et le nombre de ses « produits dérivés » comme la Classification Internationale en Soins Primaires (la CISP) qui a été construite pour permettre de classifier les éléments S, A et P.

La grille SOAP/POMR a pourtant deux inconvénients majeurs :

- Elle pose plusieurs problèmes ergonomiques, typiquement par le fait que les éléments des cases S, O et P sont assez souvent dupliqués (par exemple, un traitement peut concerner plusieurs problèmes), classiquement également par le fait que, faute de faire tenir toute la grille à l’écran, certaines interfaces présentent les problèmes sous forme d’onglets, et perdent ainsi la vision d’ensemble. En résumé, elle constitue un bon support analytique, mais une mauvaise interface.

- En organisant le flux de la consultation selon les étapes motif puis clinique et enfin diagnostic et traitement, elle est adaptée à l’aigu, mais pas au chronique qui ne voit pas seulement le patient se présenter avec une liste de motifs, mais également des problèmes et des traitements en cours (le flux de la consultation ne démarre pas uniquement avec du S, mais aussi avec le A et le P des problèmes et traitements chroniques).

Comme élément de la Ligne de vie, le Staff virtuel a été conçu à la fois comme une version plus moderne du SOAP et comme un outil destiné à faciliter le travail en équipe. Il est basé sur quatre principes directeurs :

- En tant que « tranche orthogonale du cake », il constitue un « point d’inflexion » du projet en cours : les préoccupations et traitements qui y arrivent sont éventuellement différents des préoccupations et traitements qui en partent. Au lieu d’un flux SOAP, il s’agit donc d’une transformation (A,P)SO(A’,P’).

- L’interface est conçue comme si on écartait, comme on ouvre un rideau de théâtre, la ligne verticale qui matérialise le moment présent sur la Ligne de vie, en alignant sur la marge gauche les préoccupations et traitements anciens et en réservant la marge droite pour leurs versions futures (le nouvel état du projet), et en organisant le centre du terrain de jeu sous forme de « graphe cognitif » avec une zone dédiée aux motifs de rencontre et une zone réservée aux données clinique. Il est alors possible, si besoin, de construire un graphe en reliant entre eux les éléments qui vont ensemble ou, au contraire sont en contradiction.

-

Il est possible d’inscrire des points d’interrogation lorsqu’on suppose qu’il existe un problème qu’on ne peut pas encore nommer, et/ou que le traitement doit être adapté. On peut donc exprimer l’inconnu et, si besoin, ne pas refermer la consultation et, au contraire, l’ouvrir à (tout ou partie de) l’équipe de santé afin de bénéficier d’une vision pluridisciplinaire.

Pour « résoudre les interrogations », il est alors possible de mettre en œuvre un diagramme QOC (Question, Options, Critères), qui permet au groupe de lister les options possibles et d’apporter, pour chacune d’entre elles, les critères positifs ou négatifs qui permettent in fine de travailler sur l’hypothèse qui possède le meilleur ratio +/-. - L’un des aspects importants d’une représentation de ce type est de constituer une mémoire de la prise de décision. Il est assez naturel que, dans le futur, quelqu’un s’interroge sur la raison pour laquelle un traitement a été stoppé, modifié ou instauré ou pour laquelle l’équipe a travaillé sur une hypothèse qui semble erroné. Pouvoir consulter, à l’aune des événements qui ont suivi, le raisonnement construit qui avait guidé la décision, est un élément précieux de support décisionnel.

La recherche documentaire pourrait intervenir à deux étapes en tant que support décisionnel : en utilisant le graphe de la consultation comme guide de requêtes pertinentes et, au sein du QOC, en fournissant des critères issus de la littérature.

Globalement, il faut imaginer qu’un outil construit pour permettre le travail d’équipe permet également à un acteur solitaire de bénéficier de l’apport d’agents intelligents, et, typiquement, d’un agent qui chercherait sur PUBMED si des tableaux similaires ont déjà été décrits.

AI Myths

Sunday, September 24th, 2017Perceptions of Probability

Saturday, August 26th, 2017Great way to display the fuzzy perceptions of probability attached to natural language expressions.

Past, Present and Future of AI

Saturday, May 20th, 2017Amazing panel, moderated by Diane Greene, at Google I/O ’17 about "Past, Present and Future of AI". Françoise Beaufays, Fei-Fei Li (@drfeifei), Fernanda Viégas (@viegasf) and Daphne Koller (@DaphneKoller) depict, in a truly insightful and "buzz free" way, what AI already can achieve and has the potential to become.

The whole panel is really worth watching. I selected some great sentences from Fei-Fei Li, mainly because they are less domain specific, hence easier to understand in isolation (at 8:18).

Around 2010, thanks to the convergence of the maturing of statistical Machine Learning tools, the convergence of big data brought to us by the Internet and by the sensors and the convergence of computing to more better hardware, these three pillars came together and lifted AI from the in vitro stage into what I call the in vivo stage. AI in vivo is where IA is making a real impact to the world.

It’s just the beginning. Every single industry that we see at Cloud Google is going to a transformation because of data, because of AI and Machine Learning and this is what I see as the historical moment… AI is going to impact and transform the field.

But I also do wanna say it’s just the beginning. The tools and the technologies we have developed in the field of AI are really the first few drops of water in a vast ocean of what AI can do. We cannot over promise but there should be tremendous excitement that we can do a lot of more work to make this AI in vivo happen.

Inuit cartography

Thursday, April 21st, 2016From The Decolonial Atlas. So ingenuous and inspiring.

In Kalaallit Nunaat (Greenland), the Inuit people are known for carving portable maps out of driftwood to be used while navigating coastal waters. These pieces, which are small enough to be carried in a mitten, represent coastlines in a continuous line, up one side of the wood and down the other. The maps are compact, buoyant, and can be read in the dark.

These three wooden maps show the journey from Sermiligaaq to Kangertittivatsiaq, on Greenland’s East Coast. The map to the right shows the islands along the coast, while the map in the middle shows the mainland and is read from one side of the block around to the other. The map to the left shows the peninsula between the Sermiligaaq and Kangertivartikajik fjords.

The Power of Networks

Saturday, February 20th, 2016Machine Learning Simplex

Friday, January 22nd, 2016A diagram drawn by Jason Eisner in his paper The Three Cultures of Machine Learning

According to Eisner, there are currently three cultures of machine learning. Different people or projects will fall in different places on this "ML simplex" depending on what they care about most. They start with something in green and attempt to get blue as a way of achieving red.

IBM Watson : Comment l’informatique cognitive va changer notre vie quotidienne

Thursday, September 24th, 2015Conférence de Jérôme Pesenti, vice-président Core Technology chez IBM Watson, le 23 septembre à Télécom ParisTech.

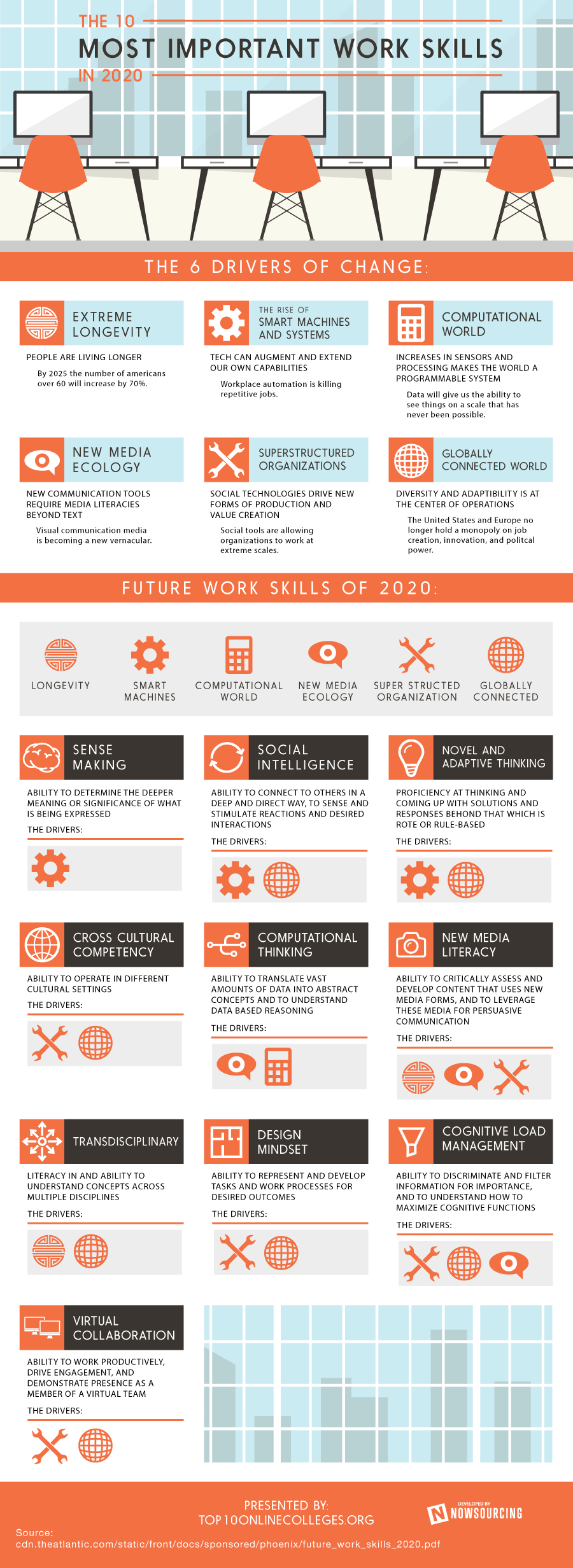

The 10 most important work skills in 2020

Friday, July 11th, 2014The best teachers…

Sunday, April 27th, 2014

The best teachers are those who show you where to look, but don’t tell you what to see. Alexandra K. Trenfor

Discontinuation of Multiple Medications in Older Adults

Saturday, April 26th, 2014Intriguing algorithm from a paper by Doron Garfinkel, MD and Derelie Mangin, MBChB freely accessible from The JAMA Network.

I wonder why it should only apply to old adults and only for discontinuation. It seems to me it should apply for anybody anytime when making a prescription.

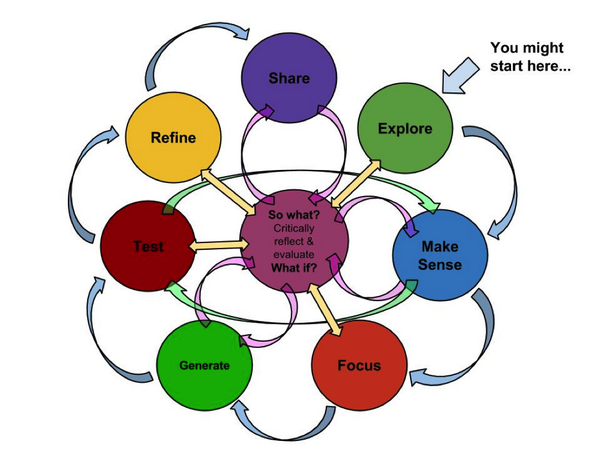

Learning complex issues

Tuesday, February 11th, 2014John Hagel: Recognizing the Power of Pull

Tuesday, December 25th, 2012I was musing at an amazing post that piles up many insightful answers to THE very question of the time: Can We Design For Breakthrough Innovation? when serendipity (what else?) just made me discover John Hagel (@jhagel) and his theory of “Pull”.

Must dig!

Dans l’esprit du Page Rank

Sunday, May 20th, 2012Mercredi 16 Mai, Antonio Casilli a clos son cycle de séminaires de l’EHESS 2011/2012 (sous la bannière « étudier les cultures du numérique : approches théoriques et empiriques ») par une belle conférence de Dominique Cardon.

Contexte savant, puisque Dominique Cardon est à la fois sociologue au Laboratoire SENSE (Orange Labs), chercheur associé au Centre d’études des mouvements sociaux (CEMS/EHESS), animateur de la revue Réseaux et auteur du livre La Démocratie Internet. Promesses et limites (Seuil, 2010).

Titre énigmatique « Dans l’esprit du PageRank. Un essai d’anthropologie de l’algorithme de Google ».

Le résultat, c’est 3 pages de notes pour une grosse heure de présentation, signe d’un discours dense et édifiant… que je vais tenter de retranscrire ici.

Introduction

L’ambition de Dominique Cardon est de scruter le web au travers des métriques qui l’organisent et des algorithmes qui les mettent en œuvre.

Sa recherche sur le Page Rank de Google s’appuie sur une lecture extensive, elle même mise en perspective sur le socle théorique des travaux sur le web politique, fortement influencé par Habermas.

L’espace politique idéal, dont le web pourrait être un exemple, est alors caractérisé par deux critères :

- une expression libre et sans contrainte,

- la force intégratrice de la discussion.

Si on peut s’accorder sur la validité du premier point, le second fait largement débat, Habermas ayant lui-même affirmé dans un discours que l’Internet est qualifié par « la fragmentation de petites niches de discussion qui n’arrivent pas à se coordonner ». Pour Dominique Cardon, les métriques et algorithmes qui classent les informations sont précisément le « lieu » où se produit cette intégration si cruciale… et méritent donc une étude attentive.

Cinq grands principes sont à la base des algorithmes qui organisent aujourd’hui le web :

- éditorialisation, le classement « manuel » par des opérateurs humains, « à la Yahoo »,

- moteurs de recherche,

- mesure d'audience,

- affinité, par exemple en fonction du volume d’abonnements sociaux,

- vitesse, classement par fraîcheur, le plus récent au dessus.

Si les trois premiers principes existent sur tous les médias, les deux derniers sont spécifiques des réseaux sociaux. La plupart des métriques qui animent les recherches au sein des sites sont bâties par agencement de ces cinq principes.

Dans l’esprit du Page Rank

La question clé posée par Dominique Cardon, sous le titre Dans l’esprit du Page Rank est « quelle est l’idée que se fait Google du web et du monde ».

L’origine du Page Rank apparaît quasi-simultanément dans la publication de Jon M. Kleinberg « Authoritative Sources in a Hyperlinked Environment » et dans celle de Brin et Page « The Anatomy of a Large Hypertextual Web Search Engine ». Son principe est de rompre avec la stratégie utilisée par les moteurs de recherche d’alors, basée sur l’analyse sémantique des pages, en partant de l’idée que, au travers des liens qui caractérisent l’environnement hypertextuel, ce sont « les pages qui parlent aux pages » et qu’il n’est pas besoin d’exhiber une logique supérieure de catégorisation.

Pour le dire plus simplement, plutôt que de tenter de trier les pages en fonction d’une arborescence artificielle de catégories, il suffit de mesurer la façon dont la connaissance s’associe (par lien hypertexte) à la connaissance. C’est une logique dite « démocratique » ; en réalité largement méritocratique puisque toutes les pages ne sont pas dotées de la même autorité.

Ainsi, le monde statistique que « dessine » le Page Rank est basé sur une forme de miracle de l’intégration réalisé par l’intelligence des foules d’internautes qui publient. Cette qualité « issue de la multitude » est, par exemple, conforme à la constatation faite par Wikipédia que les articles les plus en accord avec les critères de qualité du site sont généralement ceux qui ont le plus de contributeurs.

Dominique Cardon envisage ce mécanisme sous deux angles, une version « de gauche » et une version « de droite ».

Dans la version de gauche, décrite par Yochai Benkler, le mécanisme à l’œuvre est celui de la coordination d’actions inconscientes. Les bases du raisonnement sont fournies de longue date, par ailleurs sans rapport entre elles, par Galton (avec son expérience du poids d’un bœuf mieux approché par la moyenne des évaluations naïves que par chaque expert) et par le théorème du Jury de Condorcet, qui établit que, sous certaines conditions (que la bonne réponse ait plus d’une chance sur deux de se produire, qu’il n’y ait pas d’influence d’un votant sur l’autre et que les votants soient sincères dans leur choix), la décision du groupe est supérieure à celle de chaque individu, et sa qualité augmente avec la taille du groupe.

Dans ce cadre, le Page Rank intervient comme moteur du « modèle par la discussion » où les éléments les plus saillants des micro-discussions de niche parviennent à remonter dans des sphères plus larges qu’elles ensemencent, et ainsi de suite en faisant remonter vers le niveau global le meilleur grain des discussions locales.

Dans la version de droite, c’est le théorème de la diversité de Scott Page et la logique du marché prédictif qui servent de modèle en posant qu’il y a deux dimensions à la capacité d’un groupe à faire des prédictions intelligentes : le niveau d’expertise individuelle des membres du groupe et la diversité de leurs opinions (voir l’article de la revue Clés De Gustave Lebon à James Surowiecki : bêtise ou sagesse des foules ?).

On peut augmenter la performance prédictive du groupe en jouant sur l’une ou l’autre, ou sur les deux à la fois en attirant les opinions les plus diverses possibles, de la part de gens intéressés et même passionnés – comme le sont forcément des parieurs. Un marché prédictif attire donc les gens qui ne sont pas forcément experts, mais qui se croient bien informés (et le sont parfois), et il les pousse à oser être originaux et à ne pas être d’accord entre eux, pour parier les uns contre les autres dans l’espoir de remporter le gros lot (d’où une diversité d’opinion).

Le Page Rank est alors le moteur d’arbitrage qui, dans ce marché prédictif des opinions, permet une convergence similaire à la « main invisible » d’Adam Smith sur les marchés financiers.

Limites du modèle

Dominique Cardon insiste sur le fait que cette mécanique n’est opérante que si les acteurs ne se préoccupent pas de l’existence du Page Rank. Toutes les stratégies de Search Engine Optimization (SEO) qui visent, par des artifices multiples, à améliorer le classement d’une page contrarient le « miracle de l’agrégation » ; comparables à des délits d’initiés, ils amènent Google, qui se veut au sens propre comme au sein figuré la « main invisible » du processus, à faire sa propre justice en dégradant violemment certains sites suspectés de triche.

Google est ainsi à la fois l’ordonnanceur du Web, avec un algorithme qu’il garde secret, et le juge des bonnes pratiques, avec des adaptations non moins secrètes du même algorithme. Considération aggravante, c’est également un acteur du domaine, que ce soit par ses autres initiatives ou, surtout, par la vente d’espaces publicitaires.

Google affirme conserver un mur étanche entre le « monde organique » du web trié par le Page Rank et le « monde stratégique » des liens commerciaux. C’est une chose de faire une confiance aveugle à Google dans ses affirmations de n’avantager ni ses propres pages ni celles de ses meilleurs clients, c’en est une autre d’imaginer que la barrière soit si étanche entre un monde organique idéalement désintéressé et un monde stratégique qui resterait alors le seul espace de jeu des calculateurs.

Par ailleurs, que le modèle soit « de droite » ou « de gauche », l’Internet documentaire tel qu’il est rêvé par Google pour constituer un « espace efficient » pour le Page Rank possède une topologie de rhizome non organisé.

Pourtant, dans la réalité, 90 % du Page Rank global est réparti sur 10% des sites, situation entretenue et aggravée par l’effet Mathieu (ou effet d’avantage cumulatif) qui veut que les sites les plus visibles sont également ceux qui attirent les connexions des nouveaux entrants. Par ailleurs, la règle implicite des attachements préférentiels, qui veut qu’on « ne cite jamais plus petit que soi » aspire le Page Rank des petits sites (qui citent les gros) vers les gros (qui ne citent pas les petits).

De façon contradictoire, le Web, par l’effet du Page Rank, est donc beaucoup plus hiérarchisé et moins rhizomatique que le monde cible de Google.

L'irruption du « Web social »

L’irruption massive des réseaux sociaux, dans le sillage de l’emblématique Facebook, fait basculer le Web documentaire vers l’Internet des personnes et s’accompagne en conséquence d’un tropisme pour le classement par affinité.

Pour Dominique Cardon, la mécanique profonde du Web documentaire opère par transfert de la qualité d’un auteur à sa production ; à la façon dont le talent d’un écrivain matérialisé sous forme d’un livre permet à cet ouvrage de recevoir le Prix Goncourt.

Dans un univers hypertexte, les pages sont reliées entre elles par des liens qui matérialisent une forme de reconnaissance de valeur. Dans ces conditions, on peut modéliser le Web comme un espace autonome de documents qui emmagasinent le talent de leurs auteurs et peuvent en transférer une partie à d’autres documents par la « tuyauterie » des liens. Le Page Rank mesure alors la qualité dynamique issue de ces échanges dans un monde des documents mathématiquement parfait… car isolé de tout artifice humain.

Par ailleurs, c’est un monde relativement élitiste puisque seuls les internautes qui publient participent à l’évaluation de la qualité.

Avec la floraison des boutons « I Like It », la qualité est jugée en direct par des internautes au sein d’un cercle qui n’est plus restreint à ceux qui publient. La qualité s’attachent alors aux personnes. Comme l’exprime Dominique Cardon, on porte des badges, on investit dans la production du jugement une valorisation de soi-même.

L’application de ce principe donne vie à une nouvelle métrique, le Edge Rank, qui classe les documents en fonction des liens entre les personnes.

Conclusion

Le monde idéal du Page Rank était l’univers des documents. Par la pratique du mode rédigé, qui induit une distance suffisante entre le sujet et le sujet auteur et donne au document une qualité autonome, ce monde était partagé de façon étanche entre un domaine organique non marchand et un domaine stratégique marchand.

Le Web des personnes, au contraire, est intégralement expressif, c'est-à-dire pleinement calculateur et sensible aux pratiques complexes des sociétés humaines comme le « renvoi d’ascenseur ».

Dominique Cardon entame, par l’étude du web en fonction de ses métriques, un travail de recherche passionnant.

Mon grain de sel

En écrivant cet article, suis-je simplement sensible au mouvement « Publish What You Learn », sans autre idée que de produire un document de bonne facture… ou bien ai-je en tête de l’utiliser pour me valoriser au sein des réseaux sociaux ? Pur idéalisme ou pur calcul ?

Comme il n’existe pas de monde où les documents, détachés de leur auteur, danseraient ensemble le Page Rank, ni de société humaine fonctionnelle sans qu’il y existe un espace didactique désintéressé, je me permets d’affirmer que tout discours publié sur le Web procède simultanément des deux intentions, éclairer autrui et se valoriser.

Dans ce contexte, le Page Rank et le Edge Rank mesurent alors le succès de ces deux intentions et le monde idéal devient le lieu où celui qui avait pour but d’édifier humblement obtienne un bon Page Rank tandis que celui qui cherchait à se mettre en avant avec une production simplement voyante ou provocante voit son Edge Rank augmenté.

En prenant un peu plus de recul, je vois la démarche de Dominique Cardon comme la quête fondamentale qui consiste à analyser un espace d’échanges (le Web, ou plutôt les Webs, si on distingue ses dimensions documentaires et sociales) en fonction du mécanisme de mesure de la qualité qui s’y applique.

Comme je l’ai souvent écrit, je suis sur ce sujet un adepte de Robert M. Pirsig et de la façon dont il a défini la Qualité (avec un Q majuscule) dans son roman « Traité du zen et de l’entretien des motocyclettes » : la Qualité est la fusion de l’âme et du savoir faire technique. Le principe qui fait de l’œuvre la prolongation naturelle de la main de l’artisan ou du cerveau de l’inventeur. Elle s’oppose à la vision dualiste usuelle qui distingue fortement le concepteur et la conception, le sujet et l’objet.

Comme l’explique Pirsig, « au moment de la perception de la Qualité pure ou, sans même parler de perception, au moment de la Qualité pure, il n’existe ni sujet ni objet. Il n’existe qu’un sens de la Qualité – d’où naîtra plus tard la conscience du sujet et de l’objet. Au moment de la Qualité pure, sujet et objet sont identiques. […] Cette identité est la base même du travail artisanal, dans tous les arts appliqués. C’est elle qui manque à la technicité moderne, fondée sur une conception dualiste. Le créateur ne s’identifie nullement à ce qu’il crée, le consommateur ne s’identifie pas à ce qu’il possède ».

Nous sommes très proches de la maxime de Jacques Puisais (œnologue créateur de l’Institut du Goût) : « Un vin juste doit avoir la gueule de l’endroit où il est né et les tripes de celui qui l’a fait ». Ainsi, une « bouteille de Qualité » rassemble dans un même flacon le vigneron, sa terre et son vin.

Que le Web actuel propose des « métriques de la qualité » qui ne fonctionne que dans le monde des documents ou uniquement dans l’univers du jugement de surface du « I Like It » me semble amplement démontrer son immaturité. Immaturité qui, avec mes critères d’analyse – qui tiennent qu’un produit réussi ressemble à son auteur – est parfaitement illustré par les géants actuels du web : que ce soit Marc Zuckerberg ou Brin et Page, ce sont des êtres qu’on peut probablement qualifier de géniaux, mais dont l’humanisme est limité à la portion congrue.

En parallèle au Web « de la maison de verre » où Facebook et Google tentent de nous convaincre que l’intimité est un concept dépassé, il est urgent de créer un Internet humaniste.

Et après tout, s’il fallait, pour le construire, prendre le contrepied de la mécanique actuelle dominée par de jeunes Geeks étasuniens, ce serait un magnifique défi à relever pour les citoyens mûrs de la vieille Europe.